Social-Media Post Gen

Social-Media Post Gen using Mistral-7B-Instruct-v0.2

Abhängigkeiten

Python 3.10.6

https://www.python.org/

LLM-Modelleinstellungen

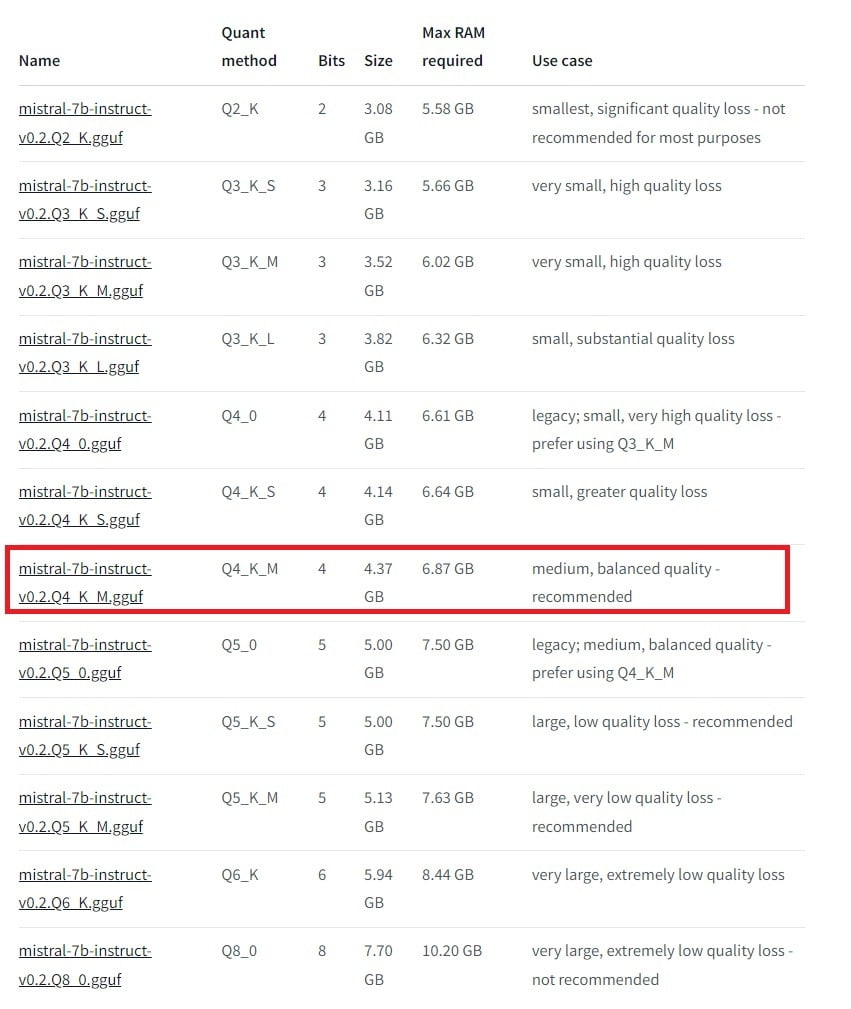

GGML_TYPE_Q4_K – „type-1“ 4-bit quantization in super-blocks containing 8 blocks, each block having 32 weights. Scales and mins are quantized with 6 bits. This ends up using 4.5 bpw.

n_gpu_layers: 32

n_ctx: 10000 (max. 32768)

Beschreibung

In diesem Projekt wird LM Studio in Verbindung mit dem Modell „TheBloke/Mistral-7B-Instruct-v0.2-GGUF“ von Hugging Face genutzt, um automatisch Social-Media-Posts für Schuhe mit einem 30% Rabatt zu generieren. Das Ziel ist es, ansprechende und kreative Texte zu erstellen, die den Nutzer zum Kauf der reduzierten Schuhe animieren.

Hardware

GeForce RTX 3070 8GB VRAM

AMD Ryzen 5 5600X 6-Core Processor, 3701 MHz, 6 Kern(e), 12 logische(r) Prozessor(en)

Generierung und Output

generate a social-media post for a shoe that has a 30% discount

Python OpenAI API – LM-Studio Local Inference Server

API-Nutzung:

- OpenAI API – LM-Studio Local Inference Server:

- Der Code verwendet die LM-Studio-API, um lokale Inferenzserver zu imitieren.

- Es werden System- und Benutzerrollen definiert, um die Informationsübermittlung an das Modell zu steuern.

- Der generierte Text wird unter Verwendung des vorgegebenen Links und mit Emojis angereichert.

Dieses Projekt ermöglicht eine automatisierte Generierung ansprechender Social-Media-Posts für Rabatt-Schuhe und kann flexibel an verschiedene Produkte und Rabattangebote angepasst werden.